Este artículo explora cómo se recuperan y analizan actualmente los datos telemáticos utilizando la API de Datos Sin Procesar de Navixy, la cual permite acceder a valiosos insights históricos. Muy pronto, con el lanzamiento de IoT Logic, la gestión de datos entrará en una nueva etapa, caracterizada por el procesamiento en tiempo real, el enriquecimiento dinámico y atributos personalizados avanzados.

Cuando se deben monitorear unas cuantas decenas de objetos, mantener la eficiencia operativa es relativamente sencillo, ya que es posible gestionar directamente las unidades y sus atributos. Sin embargo, si su flota supera las 1,000 unidades, esta tarea se vuelve considerablemente más compleja. Requiere herramientas y recursos adicionales para combinar y agregar datos que permitan un análisis posterior. Las empresas más avanzadas buscan nuevas formas de administrar y transformar los datos consolidados en información accionable.

La recopilación y consolidación manual de datos telemáticos por cada objeto puede ser extremadamente lenta. Por ejemplo, extraer y combinar los datos de un solo objeto a través de la interfaz gráfica de Navixy puede tomar alrededor de 30 segundos. Para una flota de 2,000 unidades, esta operación podría tomar más de 16 horas.

Estas operaciones se ven aún más afectadas por limitaciones tecnológicas, como la incapacidad de muchos editores de hojas de cálculo para manejar eficientemente archivos con millones de filas. Este artículo presenta las mejores prácticas para automatizar la extracción de datos utilizando un script en Python. Le brindará las herramientas necesarias para profundizar en el análisis telemático y tomar decisiones basadas en los conocimientos obtenidos.

¿Qué beneficios ofrece el big data telemático a los gestores de flotas?

Exploremos algunos casos de uso innovadores del big data telemático que van más allá de la información GPS. Imagine aprovechar datos adicionales de sensores para obtener una visión más profunda y tomar decisiones más acertadas.

Redistribución de flota para servicios de movilidad compartida. Las empresas de bicicletas y scooters compartidos buscan minimizar los tiempos de inactividad redistribuyendo estratégicamente las unidades hacia zonas de alta demanda. No obstante, muchas ciudades también quieren garantizar el acceso equitativo a opciones de movilidad. Por ejemplo, las normativas de Baltimore exigen la redistribución de unidades cuando más del 35% de la flota se concentra en una sola zona (según las NACTO Shared Micromobility Guidelines).

Optimización del flujo de pasajeros. Los sensores de conteo de pasajeros permiten identificar zonas y horarios de mayor demanda. Según la American Public Transportation Association, optimizar las rutas con base en estos datos puede reducir los tiempos de espera hasta en un 30%, mejorando la calidad del servicio y reduciendo la congestión.

Análisis de condiciones viales. Los datos de acelerómetros que registran frenadas bruscas suelen correlacionarse con malas condiciones del camino. De acuerdo con la Federal Highway Administration, mejorar las vías puede reducir los accidentes hasta en un 25%. Este enfoque también permite evaluar con mayor precisión el comportamiento del conductor, aumentando la seguridad y la eficacia de los programas de formación.

Impulso a la productividad agrícola. Los agricultores que combinan datos de sistemas GIS, rastreo GPS y sensores agrícolas han logrado incrementos en el rendimiento de hasta un 30%, en comparación con métodos tradicionales (FAO & ITU, 2022). Además, las herramientas de detección de enfermedades basadas en IA permiten una intervención temprana, reduciendo las pérdidas de cultivos entre un 30 y 40%.

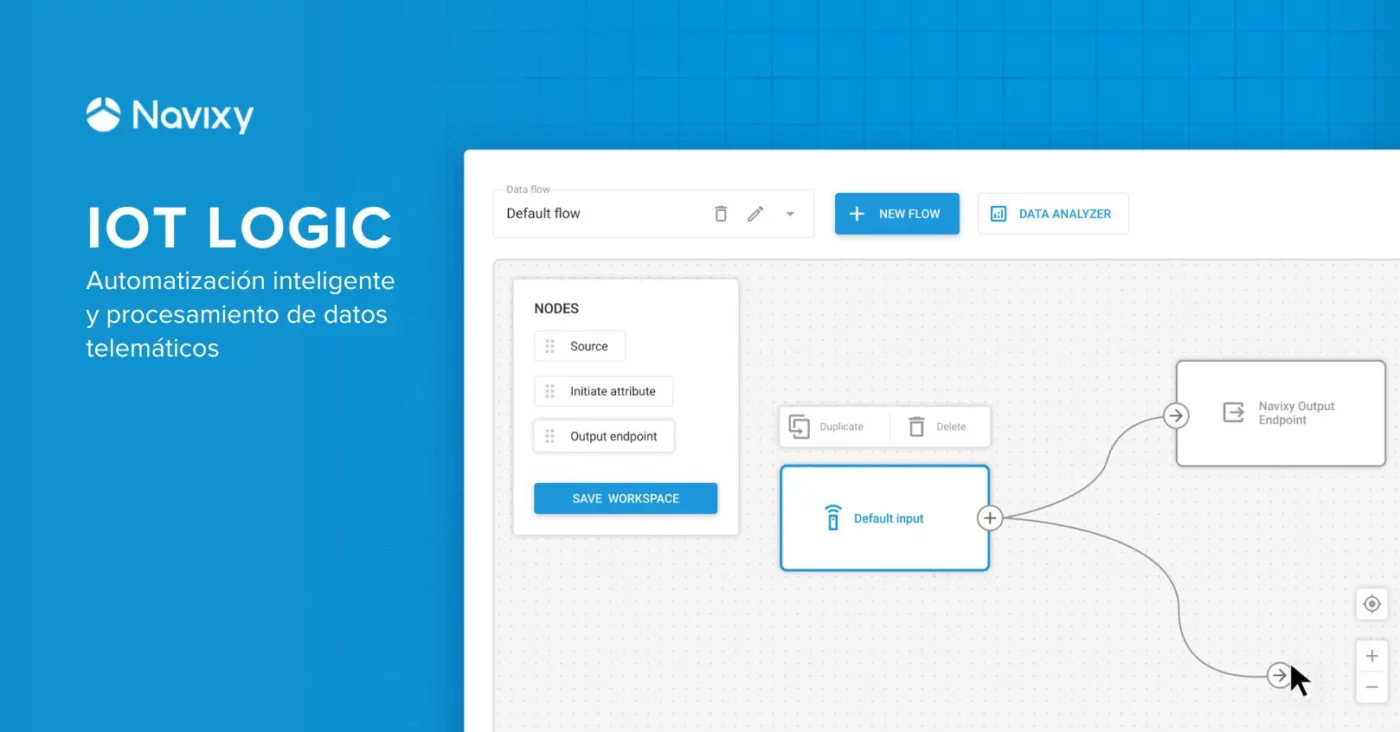

Con el próximo lanzamiento de la herramienta Navixy IoT Logic, podrá transformar estos datos en información accionable, elevando la eficiencia de su operación a un nuevo nivel.

¿Qué es el Big Data como concepto?

“Aún persiste una gran pregunta: ¿qué es realmente el big data? Mientras algunos escépticos lo descartan como una moda más en el mundo de la tecnología, otros ya están aprovechando estos datos para impulsar el crecimiento y la mejora de sus negocios. Más allá del debate, el volumen de datos no ha dejado de crecer en los últimos años. Un informe de IDC pronostica que la esfera global de datos IoT alcanzará los 175 zettabytes para 2025. Estas cifras subrayan el poder potencial del big data para la toma de decisiones en la gestión de flotas, la optimización de costos y otros objetivos estratégicos a nivel global.”

— Andrey Melnik, Product Owner del equipo Data Ops en Navixy

Los 3Vs del Big Data

El concepto de big data se caracteriza comúnmente por las 3Vs:

- Volumen: la inmensa cantidad de datos generados y recopilados.

- Velocidad: la rapidez con la que se producen y procesan estos datos.

- Variedad: la diversidad de fuentes y formatos de datos disponibles.

En Navixy, nuestra responsabilidad va más allá de estos tres elementos tradicionales. También aseguramos la Veracidad de los datos —garantizando su precisión— y extraemos Valor real de ellos. El objetivo final de Navixy es transformar los datos telemáticos en insights significativos que generen mejoras reales en el mundo físico.

¿Cómo se transforma el dato sin procesar en Big Data?

Cuando hablamos de big data, nos referimos a un enorme conjunto de datos sin procesar.

Navixy ya ha implementado una función que permite recuperar datos sin procesar de un vehículo en particular. Esto incluye datos geoespaciales, lecturas de sensores, información de estado y más —básicamente, todo lo que transmite el rastreador GPS.

Este tipo de información se utiliza generalmente para resolución de problemas:

- identificar anomalías en la operación de un rastreador,

- verificar la configuración frente a los valores reales,

- y asegurar el correcto funcionamiento del dispositivo.

Para las empresas de gestión de flotas, el big data implica un conjunto completo de datos para toda la flota, que puede utilizarse para análisis estratégicos y toma de decisiones.

Actualmente, la funcionalidad de datos sin procesar de Navixy se aplica a un objeto a la vez. En este artículo explicamos cómo automatizar el proceso de recuperación de datos y consolidarlos en un dataset apto para su análisis posterior.

¿Cómo recuperar datos telemáticos sin procesar de toda su flota?

En esta sección, describimos el proceso de uso de la API de Navixy y un script en Python para recopilar y almacenar los datos sin procesar de toda su flota con fines de análisis.

Información clave antes de comenzar

Es importante que pueda planificar el tiempo necesario para llevar a cabo estas operaciones de big data, ya que el proceso puede tomar tiempo dependiendo de:

- El rango de fechas del cual desea recuperar los datos

- La cantidad de parámetros y valores que desea obtener

Asegúrese de haber obtenido previamente su API KEY para poder realizar las consultas de datos.

Un algoritmo de recuperación de datos

Este esquema de alto nivel le brindará una comprensión general sobre la lógica del proceso de automatización para la recopilación de datos telemáticos:

Paso 1: Obtener la lista de unidades de movilidad.

- Asegúrese de tener instaladas las bibliotecas necesarias de Python (requests y pandas).

Utilizará la biblioteca requests para realizar las llamadas a la API. - Escriba un script en Python para recuperar la lista de unidades desde la API de Navixy.

- Configure los parámetros de la API:

- Defina su clave de API (API key) y la URL del endpoint correspondiente de la API de Navixy.

- Establezca los encabezados (headers) y el contenido (payload) para la solicitud. - Realice la solicitud utilizando la biblioteca requests para enviar una petición POST a la API de Navixy.

- Extraiga la lista de identificadores de rastreadores (IDs de trackers) desde la respuesta de la API.

Paso 2: Obtener los datos sin procesar de todas las unidades de movilidad.

- Extienda el script para recuperar los datos sin procesar de cada unidad utilizando la API de datos sin procesar.

- Identifique los parámetros necesarios.

-Determine qué datos desea recuperar, por ejemplo: velocidad, latitud y longitud.

- Consulte la documentación adicional para conocer la lista completa de parámetros disponibles. - Defina la solicitud a la API:

- Configure la URL, los encabezados y el contenido (payload) para la solicitud a la API de datos sin procesar.

- Establezca el rango de tiempo y las columnas que desea incluir. - Haga un ciclo sobre los IDs de los rastreadores. Para cada ID, envíe una solicitud POST a la API de datos sin procesar.

- Almacene las respuestas con los datos sin procesar en una lista.

Paso 3: Crear un único archivo con todos los datos para su análisis.

- Procese los datos sin procesar:

- Utilice la biblioteca pandas para leer los datos en un DataFrame.

- Agregue el ID del rastreador como la primera columna del DataFrame. - Verifique que todas las columnas necesarias estén presentes; complete con NULL aquellas que falten.

- Combine todos los DataFrames individuales en un solo archivo consolidado.

- Guarde el DataFrame combinado en un archivo CSV o Parquet para su análisis posterior.

| Tipo de archivo | Ventajas | Aplicaciones |

|---|---|---|

| CSV |

|

|

| Parquet |

|

|

import requests

import pandas as pd

from io import StringIO

# Step 1: Retrieve the list of tr IDs

api_key_hash = "032eaea32ad34a1acc345c2" # Replace it with your API key, TIPS: This is just code example. Avoid hardcoding API keys; use environment variables

url = 'https://api.eu.navixy.com/v2/tracker/list' # Replace it, depending on your region

headers = {'Content-Type': 'application/json'}

data = {'hash': api_key_hash}

response = requests.post(url, headers=headers, json=data)

tracker_list = response.json()['list']

tracker_ids = [tracker['id'] for tracker in tracker_list]

# Step 2: Retrieve raw data for each tr ID

raw_data_url = 'https://api.eu.navixy.com/dwh/v1/tracker/raw_data/read'

raw_data_headers = {

'accept': 'text/csv',

'Content-Type': 'application/json'

}

# TIPS: Refactor into functions for readability and reuse

# Define the time range and columns for the raw data request

from_time = "2025-01-01T00:00:00Z"

to_time = "2025-01-08T23:59:59Z"

columns = [

"lat",

"lng",

"speed"

]

# List to store DataFrames

dataframes = []

# TIPS: Consider multithreading to speed up data collection if required

for tracker_id in tracker_ids:

raw_data_payload = {

"hash": api_key_hash,

"tracker_id": tracker_id,

"from": from_time,

"to": to_time,

"columns": columns

}

raw_data_response = requests.post(raw_data_url, headers=raw_data_headers, json=raw_data_payload)

csv_data = raw_data_response.text

# Read CSV data into a DataFrame

df = pd.read_csv(StringIO(csv_data))

# Add the 'id' column as the first column

df.insert(0, 'id', tracker_id)

# Ensure all columns are present, filling missing columns with NULL

for col in columns:

if col not in df.columns:

df[col] = 'NULL'

dataframes.append(df)

# Step 3 Concatenate all DataFrames

final_df = pd.concat(dataframes, ignore_index=True)

#TIPS: Add timestamp or context to filenames for versioning if you do extraction on regular basis

# Save the final DataFrame to a CSV file

final_df.to_csv('all_raw_data.csv', index=False)

print("Data concatenation complete. Saved to 'all_raw_data.csv'.")Resultado esperado

El archivo final en formato CSV o Parquet incluirá columnas para el ID del rastreador, hora del mensaje, latitud, longitud y velocidad. Cada fila representará un paquete de datos con su propia marca de tiempo, lo que permitirá realizar cálculos y agregaciones posteriores. Consulta el ejemplo del formato de archivo CSV a continuación.

"id","msg_time","lat","lng","speed" 22334455,"2024-01-30T13:13:14+0600",4.22809,9.5264283,28 22334455,"2024-01-30T13:13:25+0600",4.228095,9.5278333,32 22334455,"2024-01-30T13:13:36+0600",4.227765,9.5293916,39 ...

Conclusión: Navixy IoT transformará sus datos en insights para el negocio

En Navixy, reconocemos la creciente demanda de big data telemático y su enorme potencial. Para responder a esta necesidad, hemos emprendido una iniciativa estratégica orientada al aprovechamiento del big data en el ámbito de la telemática.

El próximo lanzamiento de Navixy IoT Logic ofrecerá a socios y clientes las herramientas necesarias para extraer, transformar, cargar y visualizar datos telemáticos de manera sencilla. En este artículo, presentamos una solución basada en nuestra actual API de Datos Sin Procesar, complementada con un script en Python. Esta combinación permitirá a nuestros clientes recopilar y almacenar datos sin procesar de toda su flota, preparándolos para un análisis integral de big data telemático.

Esta guía le ayudará a preparar sus datos para los siguientes pasos. En nuestro próximo artículo, exploraremos métodos de preprocesamiento de datos para garantizar resultados de alta calidad.