- Las empresas impulsadas por telemática necesitan una manera de analizar eficazmente los datos en bruto de telemática, como decenas de parámetros de vehículos, para obtener conocimientos operativos más profundos.

- El formato Apache Parquet supera a los formatos tradicionales como CSV en velocidad, almacenamiento y rendimiento, especialmente para datos de IoT de alta frecuencia..

- El API de Datos en Bruto de Navixy ahora admite Parquet, permitiendo una gestión de datos optimizada y análisis más rápidos. Descubra consejos prácticos y ejemplos para optimizar la gestión de datos usando las potentes herramientas de Navixy.

Los grandes datos telemáticos requieren grandes soluciones. El API de Datos en Bruto de Navixy es su puerta de entrada a un vasto tesoro de datos en bruto de dispositivos IoT, especialmente ahora que Navixy admite Apache Parquet para gestionar los grandes datos telemáticos de manera más eficiente.

Como profesional en telemática, sabe perfectamente que manejar grandes volúmenes de datos de flujos de alta frecuencia y archivos históricos puede ser una tarea complicada. Los formatos de archivo tradicionales como CSV suelen tener dificultades con conjuntos de datos grandes, lo que ralentiza el procesamiento de datos y exige mucho almacenamiento. Esto puede obstaculizar la accesibilidad de los datos, retrasando ideas y decisiones clave para el negocio.

En este contexto, el formato de archivo Parquet puede marcar una gran diferencia, ya que ofrece una gestión de datos de alto rendimiento, un procesamiento más rápido y una reducción de almacenamiento para grandes volúmenes de datos.

Continúe leyendo para descubrir por qué Parquet es una gran ventaja, cómo funciona con el API de Datos en Bruto de Navixy y por qué debería importarle.

Parquet: el héroe de los formatos para grandes datos

Espere, ¿qué es Parquet?, se preguntará usted. No se preocupe, vamos al grano.

Para entender mejor Parquet, puede pensarlo como el primo más eficiente y moderno de CSV. Es un formato de archivo específicamente diseñado para entornos de grandes volúmenes de datos, y ahora está a su disposición a través del API de Navixy.

La clave es la siguiente: Parquet no es solo un tipo de archivo, sino más bien una herramienta que hará que sus datos sean más fáciles de acceder y analizar.

¿Por qué el formato de archivo Apache Parquet puede ser mejor para la telemetría?

Para comenzar, familiaricémonos con Apache Parquet y por qué está destinado a convertirse en una pieza clave en su caja de herramientas de datos. Es probable que se convierta en su nueva herramienta favorita.

¿Cuál es la situación con Apache Parquet?

En 2013, con la revolución de los grandes datos en pleno auge, los ingenieros de Twitter y Cloudera estaban buscando una manera más eficiente de almacenar y procesar grandes conjuntos de datos. ¿El resultado? Apache Parquet: un formato de archivo de código abierto diseñado para un almacenamiento y recuperación de datos eficiente.

Pero, ¿qué es exactamente? En términos sencillos, Parquet es un formato de archivo de código abierto diseñado para un almacenamiento y recuperación de datos eficiente. Es como un archivador altamente organizado para sus datos, donde todo está ordenado y es fácil de encontrar.

Ahora, profundicemos en las características que hacen que el formato Parquet sea especialmente adecuado para los datos de telemetría:

- Almacenamiento columnar. Imagine sus datos de telemetría como una hoja de cálculo grande y detallada. A diferencia de los formatos tradicionales basados en filas, Parquet almacena los datos columna por columna, lo que permite un análisis rápido y específico de métricas concretas. Esto significa que podrá obtener fácilmente información sobre, por ejemplo, la velocidad del vehículo o el nivel de combustible, sin tener que revisar datos no relacionados. Está diseñado para proporcionarle exactamente la información que necesita con la mínima sobrecarga.

- Compresión. Parquet utiliza algoritmos de compresión sofisticados para reducir significativamente el tamaño de los archivos. Esto es crucial para la telemetría, donde los datos se generan de manera constante y en grandes volúmenes. Al comprimir los datos a nivel de columna, Parquet minimiza los costos de almacenamiento y reduce el uso de ancho de banda al transferir datos, optimizando tanto el espacio como la velocidad.

- Esquemas de codificación avanzados. Parquet emplea una variedad de esquemas de codificación para almacenar los datos de manera eficiente. Imagine que está rastreando miles de vehículos, cada uno enviando datos cada pocos segundos. Tendrá columnas con alta repetición (ID de vehículos), otras con baja cardinalidad (códigos de estado) y otras con pequeñas variaciones (coordenadas GPS). Los esquemas de codificación de Parquet se adaptan a cada uno de estos escenarios, proporcionando un almacenamiento y un rendimiento de consulta óptimos.

En resumen, Parquet le permite almacenar y procesar grandes cantidades de datos de telemetría de manera más eficiente que los formatos tradicionales. Esto significa consultas más rápidas, menores costos de almacenamiento y la capacidad de manejar conjuntos de datos más grandes con el mismo hardware, todo lo cual son factores cruciales en la telemetría moderna.

¿Parquet vs. CSV: ¿Cuál es la diferencia?

Ahora, sabemos lo que está pensando. El formato CSV ha sido mi opción durante años. ¿Por qué debería cambiar? ¡Buena pregunta! Vamos a desglosarlo con una comparación clásica:

| Característica | Parquet | CSV |

| Tipo de almacenamiento | Columnar | Basado en filas |

| Tamaño de archivo | Más pequeño (gracias a la compresión) | Más grande |

| Desempeño de consultas | Más rápido (especialmente para consultas específicas de columnas) | Más lento |

| Gestión de esquemas | Soporte de esquema incorporado | Sin soporte de esquema |

| Preservación del tipo de datos | Preserva el tipo de datos | Todo se almacena como texto |

| Divisible para procesamiento en paralelo | Si | No (sin trabajo adicional) |

| Legible para humanos | No (formato binario) | Si |

| Compatibilidad con herramientas de grandes datos | Excelente | Buena |

Al observar esta tabla, podría estar pensando: ¡vaya, Parquet suena increíble! ¿Por qué no lo usan todos?

Bueno, la razón por la que CSV sigue teniendo su lugar es que es simple, legible por humanos y funciona bien para conjuntos de datos más pequeños o cuando necesita inspeccionar rápidamente los datos. (Y Navixy proporciona CSV, también.)

Pero cuando se trata de manejar los enormes volúmenes de datos que generan los sistemas modernos de IoT y telemática, ahí es donde el formato Parquet realmente destaca. Es como pasar de una bicicleta a un automóvil deportivo: ambos lo llevan a su destino, pero uno lo hace con mucha más potencia y eficiencia.

Así que, la próxima vez que esté luchando con un archivo CSV enorme y su computadora empiece a hacer ruido por el ventilador al máximo, recuerde que existe una forma más rápida y eficiente: Parquet.

Veamos algunos casos de uso para entender mejor cómo funciona en la práctica para profesionales que manejan datos telemáticos.

¿Quiénes pueden beneficiarse del soporte de Parquet en Navixy?

La integración del soporte de Parquet en el API de Datos en Bruto de Navixy es útil para varios roles en el ecosistema de datos, como desarrolladores de software, ingenieros de datos y analistas/científicos de datos. Entonces, ¿cómo puede beneficiarlos el uso del formato de archivo Parquet?

Desarrolladores de software: el poder de una gestión de datos eficiente

Para los desarrolladores de software que trabajan con datos telemáticos e IoT, la compatibilidad con Parquet abre nuevas posibilidades para una gestión y procesamiento de datos efectivos, con integración nativa en herramientas de big data y optimización para manejar grandes volúmenes de datos.

Integración más sencilla con herramientas y marcos de big data

El formato de archivo Parquet cuenta con compatibilidad nativa en las principales plataformas de nube, como AWS, GCP y Azure. Los archivos Parquet se pueden almacenar de forma eficiente en servicios de almacenamiento de objetos en la nube, como AWS S3, Google Cloud Storage y Azure Data Lake Storage. Esto permite una integración fluida con servicios de análisis potentes, como AWS Athena, Google BigQuery y Azure Synapse Analytics, para consultas y análisis de datos eficientes.

Mejor rendimiento de la aplicación al trabajar con grandes conjuntos de datos

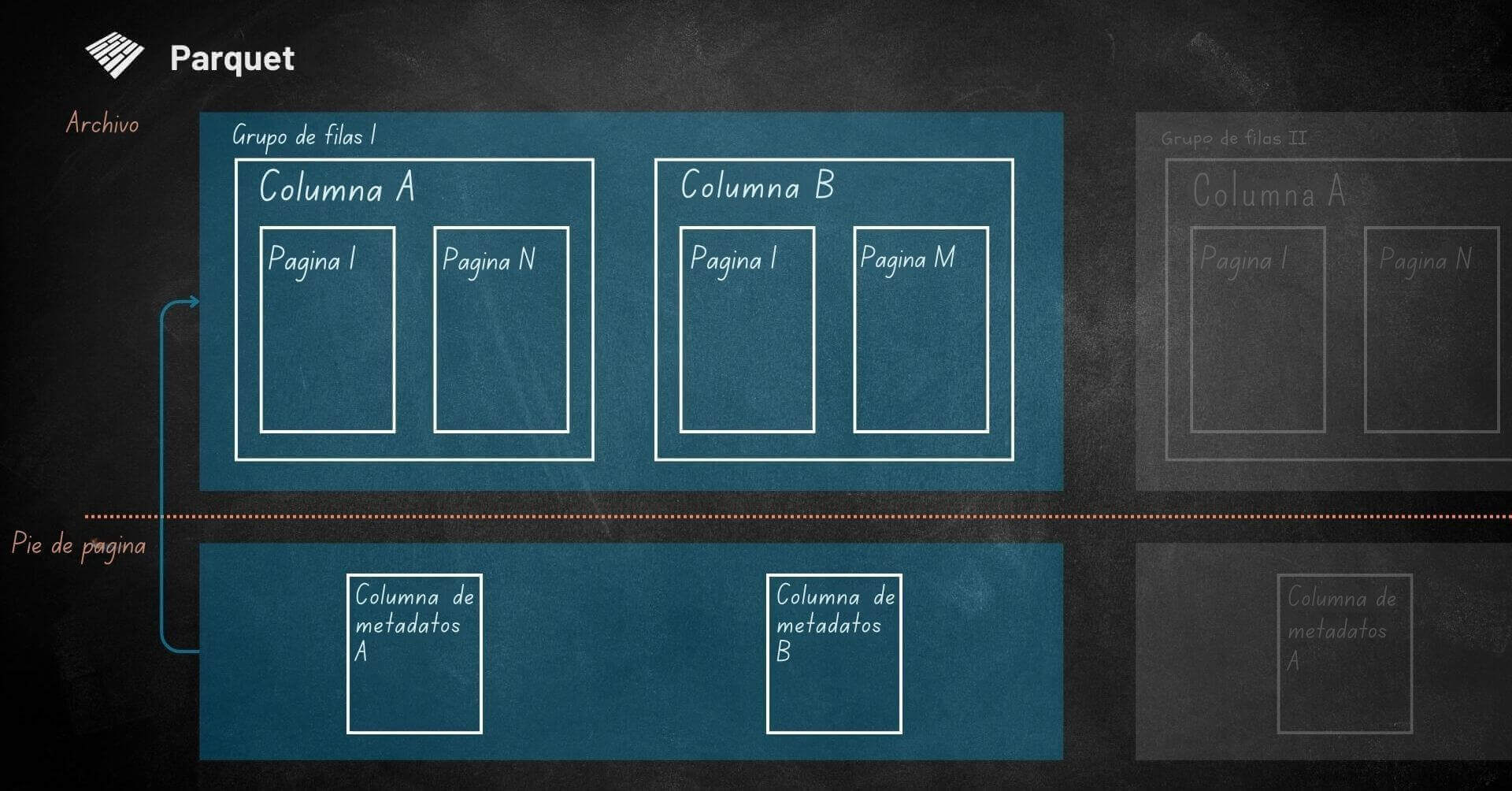

En el formato columnar de Parquet, los datos se almacenan por columna en lugar de por fila, lo que permite recuperar solo las columnas necesarias. Por ejemplo, si está analizando la velocidad del vehículo, la latitud y la longitud, Parquet lee solo esas columnas, omitiendo datos irrelevantes como la temperatura del motor o el nivel de combustible. Esto reduce la E/S de disco, ya que cada columna se almacena en bloques separados, y los metadatos en el pie de archivo ayudan a Parquet a ubicar y cargar rápidamente solo las columnas requeridas. Este acceso eficiente mejora significativamente el rendimiento, especialmente con grandes conjuntos de datos telemáticos.

Parquet también admite predicate pushdown, lo que significa que las operaciones de filtrado se pueden ejecutar en la capa de almacenamiento, reduciendo significativamente la cantidad de datos que deben leerse y procesarse. Por ejemplo, en una consulta SQL como esta:

SELECT device_id, timestamp, location FROM telemetry_data WHERE date = '2023-06-01' AND speed > 60

Predicate pushdown es, esencialmente, un término sofisticado para referirse al filtrado de datos en la capa de almacenamiento. En lugar de cargar todo un conjunto de datos en la memoria y luego aplicar los filtros, predicate pushdown permite que Parquet verifique las condiciones directamente dentro de la capa de almacenamiento.

Así es como funciona:

- Los archivos Parquet contienen metadatos que incluyen información sobre los valores mínimos y máximos en cada columna para cada grupo de filas.

- Cuando se ejecuta una consulta con una condición de filtro, Parquet primero verifica estos metadatos para determinar qué grupos de filas contienen potencialmente datos relevantes.

- Solo se leen desde el disco los grupos de filas que posiblemente cumplan con las condiciones de la consulta, lo que reduce significativamente las operaciones de E/S.

Este método a menudo reduce el volumen de datos leídos en un orden de magnitud. Por ejemplo, si está consultando datos de vehículos con una velocidad superior a un cierto umbral, la técnica de predicate pushdown permite que Parquet escanee solo los bloques relevantes que contienen datos que cumplen con estos filtros, basándose en los valores mínimos/máximos de velocidad almacenados en los metadatos.

Ingenieros de datos—optimizando pipelines de datos

Para los ingenieros de datos que utilizan Navixy, el soporte de Parquet significa procesos ETL más ágiles y una mayor eficiencia en los pipelines de datos. Los datos de telemetría de los sensores de vehículos pueden ser ingeridos y transformados hasta 3 veces más rápido, reduciendo los costos de almacenamiento hasta en un 75% y permitiendo flujos de trabajo de datos más fluidos con un mejor análisis por lotes sobre el rendimiento de la flota. Por ejemplo, en un caso de uso del tráfico de la Ciudad de México, el archivo de datos en formato Parquet era de 8 GB, en comparación con 35 GB en CSV y 57 GB en JSON.

Procesos ETL optimizados

La evolución del esquema de Parquet es una característica increíblemente útil para gestionar la naturaleza dinámica de los datos IoT de los vehículos. Es como tener una base de datos flexible que se adapta a medida que sus necesidades crecen, sin los dolores de cabeza habituales de los cambios de esquema.

Imagine que está en una empresa de arrendamiento, recopilando datos del bus CAN de una flota de camiones para operaciones de mantenimiento: seguimiento del kilometraje, estado de encendido y temperatura del motor. Todo funciona sin problemas. Luego, surgen nuevos requisitos comerciales y necesita analizar el uso de los vehículos monitoreando las revoluciones por minuto (RPM) y la posición del pedal del acelerador para entender el comportamiento del conductor. Con Parquet, agregar estos nuevos puntos de datos es muy fácil.

Además, los archivos Parquet se pueden particionar fácilmente, lo que ayuda a organizar los datos de manera eficiente. En telemetría de vehículos, puede particionar los datos por fecha y device_id, creando una estructura como esta:

/data /date=2023-06-01 /device_id=1234 0000.parquet 0001.parquet /device_id=5678 0000.parquet /date=2023-06-02 ...

Explicación de esta estructura de ejemplo:

- /data: El directorio raíz donde se almacenan todos los datos.

- /date=2023-06-01: Particionado por fecha. Toda la información del 1 de junio de 2023 se encuentra en este directorio.

- /device_id=1234: Subpartición por ID de dispositivo. Contiene los datos del dispositivo con ID 1234 para el 1 de junio de 2023.

- 0000.parquet, 0001.parquet: Archivos de datos Parquet que contienen partes de los datos de este dispositivo para la fecha especificada.

- /device_id=5678: Datos de otro dispositivo con ID 5678 para la misma fecha.

- /date=2023-06-02: Datos para el 2 de junio de 2023, con una estructura interna similar.

Con esta estructura, es sencillo recuperar y procesar subconjuntos específicos de datos. Por ejemplo, si desea analizar la actividad de un vehículo en un día determinado, puede localizar rápidamente el archivo Parquet exacto. Este acceso específico no solo acelera el procesamiento de datos, sino que también reduce las operaciones de E/S innecesarias, lo que resulta especialmente útil para grandes conjuntos de datos telemáticos.

La estructura de sus archivos Parquet debe alinearse con las necesidades específicas del consumidor de datos. Si bien ciertas estrategias de partición pueden optimizar el rendimiento para un caso de uso, podrían tener un desempeño inferior en otros. Por eso es importante comprender plenamente su caso de uso al trabajar con Parquet, asegurándose de que la estructura del archivo esté optimizada para consultas eficientes y acceso a datos según sus requisitos particulares.

Mejor eficiencia en la canalización de datos

Cuando se trata de mejorar la eficiencia en la canalización de datos, Parquet ofrece varios beneficios clave. La reducción en el uso de almacenamiento y de red, junto con un rendimiento de escritura más rápido, lo convierten en un formato ideal para manejar conjuntos de datos grandes, especialmente para datos telemáticos, que pueden crecer rápidamente.

El formato de almacenamiento columnar de Parquet está diseñado para minimizar el espacio de almacenamiento mediante el uso de algoritmos de compresión como Snappy, Gzip y LZO. Estos algoritmos reducen el tamaño de cada columna de manera independiente, lo que resulta especialmente eficiente cuando se trata de datos repetitivos, como la velocidad del vehículo o la ubicación en los datos telemáticos. Al reducir el tamaño de los archivos, Parquet ahorra en costos de almacenamiento y reduce los tiempos de transferencia de red al mover datos entre sistemas o soluciones de almacenamiento en la nube.

Otro aspecto importante de Parquet es su estructura de archivos, que admite una lectura y procesamiento eficientes. Cada archivo Parquet está marcado con los bytes mágicos 'PAR1' al principio y al final. Esta estructura permite un trabajo más rápido con archivos existentes, ya que ayuda a los sistemas a identificar y validar rápidamente los archivos Parquet.

Sin embargo, es importante señalar que los archivos Parquet no están diseñados para la adición directa de nuevos datos. En su lugar, cuando se trata de datos en tiempo real o actualizados con frecuencia, como en aplicaciones de telemetría, el enfoque típico es crear nuevos archivos Parquet para los nuevos lotes de datos.

Este enfoque es particularmente valioso en telemetría, donde los flujos de datos son continuos y se genera información nueva, como posiciones de vehículos, lecturas de sensores o métricas de comportamiento del conductor, con frecuencia. El formato Parquet permite la creación eficiente de nuevos archivos, que luego pueden integrarse fácilmente en los flujos de trabajo de procesamiento de datos.

Para escenarios que requieren actualizaciones frecuentes, tecnologías construidas sobre Parquet, como Apache Iceberg o Delta Lake, ofrecen características adicionales para gestionar conjuntos de datos en evolución, manteniendo los beneficios de rendimiento del almacenamiento columnar de Parquet.

Analistas de datos y científicos: acceso más rápido a los conocimientos

Para quienes trabajan en la extracción de conocimientos a partir de datos de telemetría, el soporte de Parquet puede acelerar significativamente los flujos de trabajo.

Exploración y análisis de datos más rápidos

La consulta eficiente y el fácil acceso a los metadatos agilizan el proceso de análisis, permitiendo a los usuarios recuperar rápidamente puntos de datos específicos y obtener información sin tener que escanear conjuntos de datos completos. Esta eficiencia no solo reduce el tiempo de procesamiento, sino que también agrega flexibilidad a los flujos de trabajo al permitir filtrado, ordenamiento y agregación rápidos de datos.

El formato columnar permite agregaciones y operaciones de filtrado rápidas. Por ejemplo, usando PyArrow de Python:

import pyarrow.parquet as pq

table = pq.read_table('navixy_data.parquet')

filtered_table = table.filter((table['speed'] > 60) & (table['fuel_level'] < 20))

print(filtered_table.to_pandas())Los archivos Parquet incluyen metadatos que se pueden acceder instantáneamente, eliminando la necesidad de escanear todo el archivo. Con el almacenamiento de metadatos, incorporado de Parquet, los usuarios pueden revisar resúmenes detallados de los datos e información del esquema desde el principio, obteniendo una comprensión clara de la estructura y el contenido del conjunto de datos antes de profundizar en el análisis. Esto permite una comprensión rápida de las características de los datos:

parquet_file = pq.ParquetFile('navixy_data.parquet')

print(parquet_file.metadata)

print(parquet_file.schema)Mayor compatibilidad con herramientas populares de ciencia de datos

El formato Parquet se integra de manera fluida en el ecosistema de Python y es altamente escalable, lo que lo convierte en una opción ideal para los flujos de trabajo de ciencia de datos en Python y R.

Bibliotecas como Pandas, PyArrow y Dask ofrecen un sólido soporte para archivos Parquet, lo que permite una gestión y análisis de datos eficientes:

import pandas as pd

df = pd.read_parquet('navixy_data.parquet')

print(df.describe())En R, el paquete arrow proporciona una integración fluida con Parquet, lo que permite a los usuarios trabajar con archivos Parquet de la misma manera que lo harían con los marcos de datos nativos de R.

library(arrow)

df <- read_parquet("navixy_data.parquet")

summary(df)A medida que los conjuntos de datos superan los límites de memoria, Dask en Python permite un procesamiento escalable y fuera de núcleo para archivos Parquet, lo que le permite trabajar con conjuntos de datos grandes de manera efectiva.

import dask.dataframe as dd

ddf = dd.read_parquet('navixy_data.parquet')

result = ddf.groupby('device_id')['speed'].mean().compute()La popularidad de Parquet y el siguiente paso con Delta Lake

Investigaciones recientes destacan el creciente dominio de Parquet en el ámbito de los grandes datos. Un estudio realizado por Dong et al. (2023) encontró que el uso de Parquet aumentó un 45% en industrias intensivas en datos durante tres años, superando formatos como Avro y ORC. De manera similar, Sharma y Gupta (2022) reportaron que el 68% de los ingenieros de datos prefieren Parquet por su rendimiento de consulta y eficiencia en el almacenamiento. Chen et al. (2024) también mostraron que el 72% de las nuevas implementaciones de lagos de datos utilizan Parquet, gracias a su compresión e integración sin problemas con herramientas de grandes datos.

Colectivamente, estos hallazgos subrayan la creciente popularidad de Parquet, particularmente en sectores que gestionan grandes y complejos conjuntos de datos como los de telemetría e IoT.

Para las organizaciones que buscan una infraestructura de datos aún más robusta, Delta Lake construye sobre la base de Parquet con características como consistencia transaccional, evolución de esquemas y versionado. A menudo llamado Parquet mejorado, Delta Lake permite una gestión de datos confiable y análisis avanzados, lo que lo hace ideal para conjuntos de datos de alta velocidad y complejos.

Ahora, pasemos de la teoría a la práctica y veamos cómo trabajar con el formato de archivo Parquet en el API de Datos en Bruto de Navixy.

Cómo recuperar datos en formato Parquet utilizando el API de Datos en Bruto de Navixy.

Ahora, repasemos cómo puede comenzar a aprovechar el formato Parquet con el API de Navixy para gestionar datos en bruto, junto con la opción CSV familiar, utilizando el nuevo parámetro de format en el método raw_data/read.

Nuevo parametro: format

Para admitir la opción Parquet, hemos agregado un nuevo parámetro al punto de acceso /raw_data/read:

format: Especifica el formato de salida. Acepta "csv" (predeterminado) o "parquet".

Llamada al API actualizada

Aquí le mostramos cómo utilizar el API actualizada para recuperar datos en formato Parquet utilizando un script bash en Linux:

#!/bin/bashcurl -X 'POST' \

'https://api.eu.navixy.com/dwh/v1/tracker/raw_data/read' \

-H 'accept: application/octet-stream' \

-H 'Content-Type: application/json' \

-d '{

"hash": "feed000000000000000000000000cafe",

"tracker_id": "3036057",

"from": "2024-09-10T02:00:00Z",

"to": "2024-09-10T06:00:00Z",

"columns": [

"lat",

"lng",

"speed",

"inputs.can_fuel_litres"

],

"format": "parquet"

}' \

--output navixy_data.parquetEche un vistazo rápido al video a continuación para ver cómo se puede hacer, paso a paso.

Cambios clave:

- El parámetro "format": "parquet" se agrega al cuerpo de la solicitud. El encabezado de aceptación se establece en application/octet-stream para manejar los datos binarios de Parquet.

Gestión de la respuesta

Cuando solicite el formato Parquet, recibirá una secuencia de archivo binario en lugar de una cadena CSV. Aquí hay una forma rápida de guardar estos datos como un archivo usando Python:

import requests

url = "https://api.eu.navixy.com/dwh/v1/tracker/raw_data/read"

headers = {

"accept": "application/octet-stream",

"Content-Type": "application/json"

}

data = {

"hash": "feed000000000000000000000000cafe",

"tracker_id": "3036057",

"from": "2024-09-10T02:00:00Z",

"to": "2024-09-10T06:00:00Z",

"columns": [

"lat",

"lng",

"speed",

"inputs.can_fuel_litres"

],

"format": "parquet"

}

response = requests.post(url, headers=headers, json=data)

if response.status_code == 200:

with open("navixy_data.parquet", "wb") as f:

f.write(response.content)

print("Parquet file saved successfully!")

else:

print(f"Error: {response.status_code}, {response.text}")Puede ver el video a continuación para obtener una mejor comprensión del proceso.

Leyendo el archivo Parquet.

"Una vez que haya guardado el archivo Parquet, puede leerlo con PyArrow o Pandas para explorar y analizar sus datos. Instale la utilidad parquet-cli (que incluye las bibliotecas PyArrow y Pandas)."

pip install parquet-cli

Realizar lectura:

import pyarrow.parquet as pq

# Read the Parquet file

table = pq.read_table("navixy_data.parquet")

# Convert to a Pandas DataFrame if needed

df = table.to_pandas()

print(df.head())También sería útil complementar este ejemplo con la lectura del archivo Parquet utilizando la utilidad Parquet CLI.

Abra el archivo previamente descargado utilizando el siguiente conjunto de comandos:

parq navixy_data.parquet parq navixy_data.parquet --schema parq navixy_data.parquet --head 5 parq navixy_data.parquet --tail 5

Compatibilidad con versiones anteriores

No se preocupe si aún no está listo para cambiar a Parquet. El API utiliza CSV de forma predeterminada si no se especifica un formato, por lo que las integraciones existentes funcionarán sin problemas y sin necesidad de modificaciones.

Mejores prácticas

Si considera que debe optar por el formato Parquet, podría ser útil revisar las siguientes mejores prácticas.

- Seleccione las columnas de manera reflexiva: con Parquet, es aún más eficiente recuperar solo las columnas que necesita.

- Optimice los rangos de tiempo: dividir las solicitudes en bloques de tiempo más pequeños puede facilitar el procesamiento en paralelo.

- Utilice los metadatos de Parquet: herramientas como PyArrow le permiten inspeccionar los esquemas y estadísticas de los archivos Parquet sin cargar el archivo completo, lo que ahorra tiempo de procesamiento.

¿Está listo para probar Parquet? Comience hoy

Para concluir, agregar el formato Apache Parquet a el API de Datos en Bruto de Navixy es un cambio de juego para cualquiera que trabaje con datos de telemetría. Ayuda a ahorrar espacio, acelera el procesamiento de datos y facilita la gestión de grandes volúmenes de datos. Para los profesionales de datos de telemetría, puede resultar en insights más rápidos, una gestión de datos más fluido y una manera más eficiente de trabajar con conjuntos de datos complejos, aprovechando al máximo los datos de telemetría, sin complicaciones.

Si esto le resulta interesante y aún no está utilizando el API de Datos en Bruto de Navixy, ahora es el momento de descubrir lo que se está perdiendo. Con nuestro último soporte para Parquet, puede optimizar el procesamiento de datos, reducir los costos de almacenamiento y sumergirse en los insights de telemetría como nunca antes.